Was steckt hinter den Grundkonzepten von ChatGPT?

Es gibt derzeit so viel Aufregung, Vorfreude und Angst bezüglich ChatGPT, aber kaum etwas, das erklärt, wie es funktioniert. Sicherlich gibt es viele technische Papiere und dergleichen, aber für den Durchschnittsbürger können sie etwas abschreckend sein.

Dieser Artikel zielt darauf ab, eine einfache Sichtweise darauf zu präsentieren, wie ChatGPT und verwandte KI-Technologien funktionieren, ohne zu sehr ins Detail zu gehen. Natürlich wird es Fachbegriffe geben, aber ich werde versuchen, sie auf verständlichere Weise zu erklären. Dies mag ein ehrgeiziges Ziel sein (wie man etwas erklärt, ohne es zu erklären), aber ich werde mein Bestes geben.

Der ChatGPT-Algorithmus

Beginnen wir damit, zu erklären, was ChatGPT ist und wie der ChatGPT-Algorithmus funktioniert.

ChatGPT

ChatGPT ist ein Chatbot, ein Computerprogramm, das Konversationen mit menschlichen Benutzern simulieren kann. Chatbots verwenden Natural Language Processing (NLP), um die Eingabe des Benutzers zu verstehen und eine relevante Antwort auf die Frage oder Anfrage des Benutzers zu generieren. NLP ist ein Bereich der KI, der sich mit der Interaktion zwischen Computern und menschlicher Sprache befasst.

ChatGPT verwendet GPT (Generative Pre-trained Transformer), ein grosses Sprachmodell, das von OpenAI entwickelt wurde. Neben ChatGPT gibt es auch andere ähnliche Chatbots wie Bard von Google und Claude von Anthropic. Weitere bekannte Chatbots sind Siri von Apple, Alexa von Amazon und der Google Assistant.

Grosse Sprachmodelle

Große Sprachmodelle (LLMs) sind KI-Modelle, die menschliche Sprache erlernen und generieren können. LLMs sind ein wesentlicher Bestandteil von NLP. Einige der bekannten LLMs sind GPT von OpenAI, LaMDA (Language Model for Dialogue Applications) von Google und LLaMA (Large Language Model Meta AI) von Meta. Diese Modelle lernen aus einer grossen Menge an Textdaten und verwenden ihr Wissen, um neuen Text zu generieren oder zu verstehen.

Die grundlegende Idee hinter LLMs besteht darin, das nächste Wort in einer Sequenz vorherzusagen, basierend auf den zuvor verwendeten Worten.

Zum Beispiel, wenn du diese Wortfolge hast:

A quick brown fox jumps over the lazy

Das LLM wird das nächste Wort vorhersagen:

A quick brown fox jumps over the lazy dog

Es verwendet dazu eine KI-Technik namens maschinelles Lernen.

Machine Learning

Machine Learning ist eine Familie von KI-Algorithmen, bei denen grosse Datenmengen verarbeitet werden, um ein KI-Modell zu trainieren, das Entscheidungen trifft.

Angenommen, du möchtest einem Kind beibringen, wie ein Hund aussieht. Du könntest ihm viele Bilder von verschiedenen Hunden zeigen. Nachdem das Kind genug Bilder von Hunden gesehen hat, beginnt es zu verstehen, welche charakteristischen Merkmale Hunde tendenziell haben – sie haben vier Beine, einen Schwanz, können unterschiedliche Grössen haben, aber ihre Gesichter haben ähnliche Strukturen und so weiter. Wenn das Kind einen Hund sieht, den es noch nie zuvor gesehen hat, kann es aufgrund der gelernten Muster erkennen, dass es sich um einen Hund handelt.

Maschinelles Lernen funktioniert auf ähnliche Weise. Angenommen, wir möchten das nächste Wort nach einer Wortsequenz vorhersagen. Wir geben dem Computer zunächst eine grosse Menge an Textdaten. Das können Bücher, Artikel, Websites oder alles Mögliche mit Wörtern sein. Während des Trainings lernt das Modell die Sprachmuster. Dies wird als Trainingsdaten bezeichnet. Es lernt, dass bestimmte Wörter oft zusammen auftreten (wie „braun“ und „Fuchs“) und dass es Regeln in der Sprache gibt, denen wir normalerweise folgen (wie wir Adjektive in der Regel vor die von ihnen beschriebenen Nomen stellen). Schliesslich werden diese Muster zu einem Modell – einer Reihe von gelernten Regeln, die es verwenden kann, um das nächste Wort vorherzusagen.

Der grundlegende Baustein der im LLM verwendeten maschinellen Lernalgorithmen ist das neuronale Netzwerk.

Neuronales Netzwerk

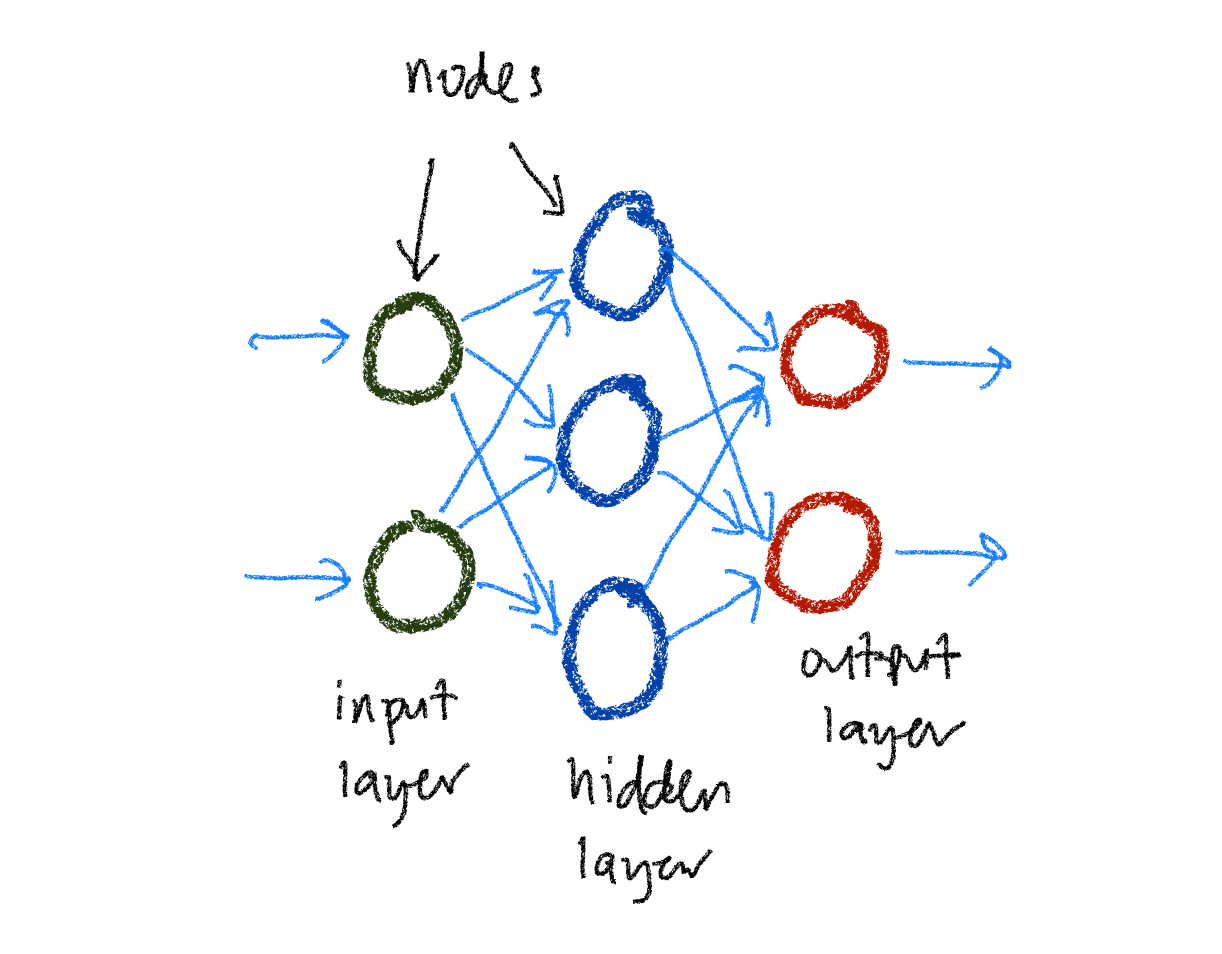

Ein neuronales Netzwerk ist ein maschinelles Lernalgorithmus, der so funktioniert, wie wir glauben, dass das menschliche Gehirn arbeitet. Es besteht aus vielen kleinen Teilen, die Knoten oder Neuronen genannt werden und in Schichten gruppiert sind, die zusammenarbeiten, um aus Daten zu lernen.

Die Lernphase eines neuronalen Netzwerks erfolgt während eines Prozesses namens Training. Nehmen wir das vorherige Beispiel, so dass wir das nächste Wort in einem Satz vorhersagen möchten.

Zunächst müssen wir vor dem Training die Trainingsdaten in Sequenzen bestimmter Längen aufteilen, sagen wir 10 Wörter, um das nächste Wort nach der Sequenz vorherzusagen.

Als nächstes wandeln wir die Wörter in den Sequenzen in Vektoren um, im Wesentlichen eine Liste von Zahlen. Dieser Vorgang wird als Einbettung bezeichnet, und die Vektoren werden manchmal als Einbettungen oder Wortvektoren bezeichnet. Wörter, die einander ähnlich sind, haben ähnliche Vektoren.

Um das neuronale Netzwerk zu trainieren, füttern wir die Sequenzen von Einbettungen nacheinander ein. Nach jedem Wort aktualisiert das neuronale Netzwerk seinen internen Zustand, der aus Knoten besteht, die in Schichten gruppiert sind, je nachdem, was es gelernt hat. Wenn alle Einbettungen einer Sequenz in das neuronale Netzwerk eingespeist wurden, bitten wir es um eine Vorhersage.

Die vorhergesagte Einbettung wird mit der tatsächlichen Einbettung für das nächste Wort in der Sequenz verglichen. Der Unterschied zwischen diesen Einbettungen ist der Vorhersagefehler, der verwendet wird, um den internen Zustand des neuronalen Netzwerks durch einen Prozess namens Backpropagation anzupassen. Die Anpassungen erfolgen so, dass die vorhergesagte Einbettung der tatsächlichen Einbettung näherkommt.

Dieser Prozess wiederholt sich, und das neuronale Netzwerk wird mit allen Trainingsdaten trainiert, bis es sehr gut darin ist, das nächste Wort in einem Satz herauszufinden. Nach Abschluss des Trainings kann das Modell nun Vorhersagen treffen. Der Prozess, bei dem ein Modell zur Vorhersage aufgefordert wird, wird als Inferenz bezeichnet.

Frühe neuronale Netzwerke hatten eine geringe Anzahl von Knoten und Schichten. Mit zunehmender Verfügbarkeit von Trainingsdaten und der Entwicklung raffinierterer Methoden zur Organisation der Knoten wurde die Anzahl der Knoten und Schichten jedoch enorm, in Millionen und Milliarden. Ein weiterer Begriff für Algorithmen mit solch grossen neuronalen Netzwerken ist Deep Learning. Das Wort Deep in Deep Learning bezieht sich auf die Anzahl der Schichten in den versteckten Schichten.

Frühere neuronale Netzwerk-Algorithmen wie rekurrente neuronale Netzwerke (RNN) und Long Short-Term Memory (LSTM)-Netzwerke wurden häufig in der natürlichen Sprachverarbeitung (NLP) verwendet, haben jedoch Stabilitätsprobleme bei sehr langen Textsequenzen.

Im Jahr 2017 veröffentlichte Google ein Paper, in dem der Transformer, ein Typ neuronales Netzwerk, vorgestellt wurde, der die NLP enorm verbesserte und plötzlich alles veränderte.

Transformers

Angenommen, du unterhältst dich mit einer Gruppe von Freunden darüber, einen Filmabend zu planen. Wenn einer deiner Freunde etwas sagt, verstehst du seine Worte nicht nur aufgrund dessen, was er gerade gesagt hat, sondern du berücksichtigst die gesamte Unterhaltung — über welchen Film ihr gesprochen habt, wer wann verfügbar ist, welche Snacks ihr plant zu besorgen und so weiter. Transformers tun etwas Ähnliches, insbesondere wenn es um Sprache geht.

Ein Transformer ist eine Art von neuronalem Netzwerkalgorithmus, der besonders gut mit Kontext in Daten umgehen kann. Er beschränkt sich nicht darauf, nur das aktuell verarbeitete Datenstück (wie ein Wort in einem Satz) und das unmittelbar vorherige Datenstück zu betrachten. Stattdessen kann er alle Datenpunkte (alle Wörter im Satz) berücksichtigen, herausfinden, welche für den aktuellen Datenpunkt (das Wort) am relevantesten sind, und diese nutzen, um den aktuellen Datenpunkt besser zu verstehen.

Lass uns einen Satz als Beispiel nehmen:

Obwohl ich bereits zu Abend gegessen habe, habe ich immer noch Hunger.

Wenn ein Transformer das Wort Hunger verstehen möchte, betrachtet er nicht nur die unmittelbar vorhergehenden Wörter wie habe ich immer noch. Er berücksichtigt auch zu Abend gegessen aus früheren Teilen des Satzes, da es relevant ist, um zu verstehen, warum jemand Hunger haben könnte.

Diese Fähigkeit stammt von dem Aufmerksamkeitsmechanismus, den Transformers verwenden. Dieser ermöglicht es ihnen, aufgrund ihrer Relevanz verschiedene Teile der Eingabedaten zu beachten. Das macht Transformers hervorragend für Aufgaben wie maschinelle Übersetzung und Textgenerierung, bei denen das vollständige Verständnis des Kontexts der Eingabedaten entscheidend ist.

Alle kürzlich erstellten LLMs, einschliesslich GPT, basieren auf Transformers.

Tokens

Wir haben über Wörter in einem Satz für das Training oder die Inferenz gesprochen, aber tatsächlich arbeiten LLMs nicht mit Wörtern. Stattdessen verwenden sie Tokens.

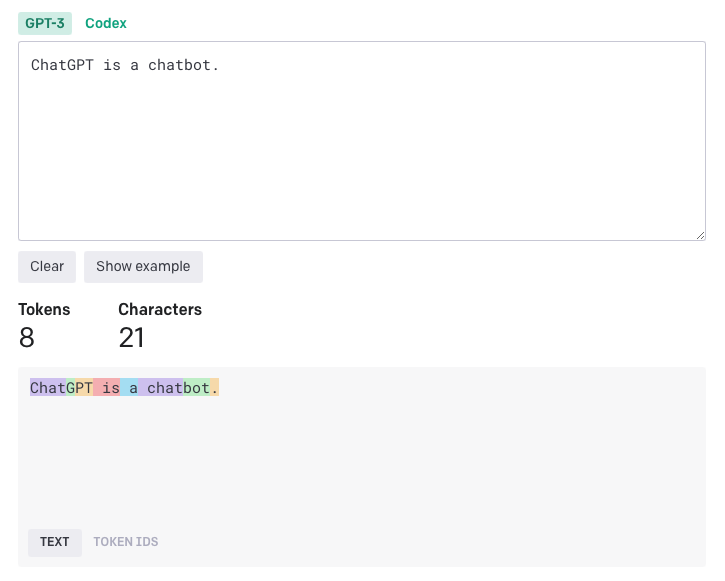

Ein Token ist ein Textabschnitt. Häufige und kurze Wörter entsprechen in der Regel einem einzelnen Token. Lange und seltener verwendete Wörter werden in der Regel in mehrere Tokens aufgeteilt. Du kannst direkt OpenAI-Tokenizer deinen Text eingeben und sehen, wie er in Tokens aufgeteilt wird.

Du fragst dich vielleicht, warum die Wörter auf diese Weise tokenisiert werden.

Angenommen, wir verwenden jeden Buchstaben als Token. Dadurch wird der Text in Tokens aufgeteilt und die Gesamtzahl der verschiedenen Tokens klein gehalten. Allerdings können wir nicht annähernd so viele Informationen codieren. Im obigen Beispiel können 8 Tokens nur ChatGPT codieren, während 8 OpenAI-Tokens den ganzen Satz codieren können. Aktuelle LLMs haben eine Begrenzung für die maximale Anzahl von Tokens, die sie verarbeiten können, daher möchten wir so viele Informationen wie möglich in jedem Token packen.

Was ist, wenn jedes Wort ein Token ist? Im Vergleich zum Ansatz von OpenAI würden wir nur 5 Tokens benötigen, um denselben Satz darzustellen, was effizienter ist. Allerdings müssen LLMs eine vollständige Liste der Tokens haben, auf die sie stossen könnten, und diese Methode kann nicht mit erfundenen Wörtern (sehr häufig in der Fiktion) oder fachspezifischen Wörtern (sehr häufig in technischen Dokumenten) umgehen.

Training von ChatGPT

Nun, da wir den ChatGPT-Algorithmus verstehen, wollen wir verstehen, wie er trainiert wurde. Fangen wir mit einigen Grundlagen des überwachten und unüberwachten Lernens an.

Beim überwachten Lernen handelt es sich um eine Art des maschinellen Lernens, bei dem wir dem Modell Eingabedaten und die richtigen Ausgaben zur Verfügung stellen. Angenommen, du möchtest ein Modell trainieren, um Nachrichtenartikel in verschiedene Kategorien wie Wirtschaft, Sport oder Unterhaltung zu klassifizieren. Du würdest damit beginnen, einen Datensatz mit gekennzeichneten Nachrichtenartikeln zu sammeln. Für jeden Artikel würdest du ihn manuell mit der entsprechenden Kategorie kennzeichnen. Sobald du den Datensatz hast, kannst du ihn verwenden, um das Modell zu trainieren.

Beim unüberwachten Lernen hingegen geht es um unlabeled Daten. Dem Modell werden Eingaben gegeben, aber es gibt keine expliziten korrekten Ausgaben. Das Modell muss selbstständig Strukturen in den Eingaben finden. Ein Beispiel hierfür ist das Clustering, bei dem das Modell ähnliche Daten gruppiert.

Vor GPT wurden die meisten NLP-Modelle mit überwachtem Lernen für spezifische Zwecke wie Textklassifikation oder Sentimentanalyse trainiert. Das Problem dabei ist, dass es schwierig ist, grosse Mengen an gekennzeichneten Daten zu finden. Ausserdem sind diese Modelle sehr spezialisiert und können nur für den Zweck verwendet werden, für den sie trainiert wurden.

GPT wird jedoch zunächst mit unüberwachtem Lernen auf unlabeled Daten vortrainiert und dann mit überwachtem Lernen für spezifische Aufgaben feinabgestimmt.

Feinabstimmung

Im maschinellen Lernen gibt es das Konzept des Transferlernens. Die Idee besteht darin, ein Modell, das für eine Aufgabe trainiert wurde, als Ausgangspunkt für eine verwandte Aufgabe zu verwenden. Dies ist sehr nützlich, da das Training dieser Modelle von Grund auf viel Daten und Rechenressourcen erfordern kann.

Feinabstimmung ist eine spezifische Art des Transferlernens. Im Zusammenhang mit GPT bedeutet Feinabstimmung, dass das Modell, das bereits auf einer großen Menge von Textdaten trainiert wurde (die Vortrainierungsphase), anschließend auf eine spezifischere Aufgabe weiter trainiert wird.

Nehmen wir als Beispiel an, du hast ein GPT-Modell, das auf einer grossen Menge an Internettext vortrainiert wurde. Nun möchtest du einen Chatbot erstellen, der Ratschläge zur gesunden Ernährung gibt. Das GPT-Modell hat während des Vortrainings viel über Sprache gelernt, ist jedoch möglicherweise nicht sehr gut darin, spezifische Ratschläge zur Ernährung zu geben.

Daher sammelst du einen Datensatz von Unterhaltungen, in denen Menschen gute Ratschläge zur gesunden Ernährung geben. Anschliessend nimmst du dein vortrainiertes GPT-Modell und stimmst es mit diesem neuen Datensatz ab. Das Modell hat nun aus deinen spezifischen Unterhaltungen über Ernährungsratschläge gelernt und seine Parameter leicht angepasst, um in dieser Aufgabe besser zu werden.

Im Wesentlichen ermöglicht uns die Feinabstimmung, ein allgemeines Modell für spezifische Aufgaben anzupassen, sodass es für unterschiedliche Zwecke nützlicher und effizienter wird. Der Vorteil besteht darin, dass wir kein komplexes Modell wie GPT von Grund auf trainieren müssen, was erhebliche Zeit-, Daten- und Rechenressourcen sparen kann.

Außerdem stellte sich heraus, dass GPT-Modelle, die nur vortrainiert und nicht feinabgestimmt wurden, für sich genommen recht leistungsfähig sind. Modelle, die trainiert, aber nicht feinabgestimmt werden, werden als foundation models bezeichnet.

Verschiedene Typen von Modellen

Modelle können für verschiedene Aufgaben trainiert werden (oder Foundation-Modelle können feinabgestimmt werden). Wenn du zum Beispiel ein Completion-Modell verwendest, könntest du ihm einen solchen Prompt geben:

Es war einmal, in einem weit entfernten Königreich

Das Modell nimmt diesen Prompt und generiert den Rest des Textes wie folgt:

Es war einmal, in einem weit entfernten Königreich, ein tapferer Ritter und ein furchteinflößender Drache.

Die meisten Sprachmodelle sind minimale Completion-Modelle.

Ein konversationales Modell (wie ChatGPT) wird mit konversationellen Daten trainiert, wie zum Beispiel Dialoge aus Büchern, Drehbüchern oder Transkriptionen gesprochener Unterhaltungen. Dadurch lernt das Modell die hin- und hergehende Natur von Unterhaltungen zu verstehen, einschliesslich der Beziehung zwischen Antworten und vorherigen Nachrichten.

Ein Anweisungs-Modell (wie InstructGPT) wird darauf trainiert, menschliche Anweisungen zu verstehen und darauf zu reagieren. Dies kann Trainingsdaten umfassen, die aus Befehlen und den entsprechenden Handlungen oder Anweisungen und den entsprechenden Antworten bestehen.

Ein Frage-und-Antwort (Q&A)-Modell wird mit Daten trainiert, die Fragen mit ihren Antworten beinhalten, wie zum Beispiel Daten von Q&A-Websites, Lehrbüchern oder anderen Bildungsressourcen. Dadurch lernt das Modell, informative und präzise Antworten auf direkte Fragen zu geben.

ChatGPT training

ChatGPT basiert auf GPT-3.5, bzw. GPT4, und wird dann zweimal feinabgestimmt – zunächst mithilfe von überwachtem Lernen und anschließend mithilfe von verstärkendem Lernen.

Im ersten Schritt, dem überwachten Feinabgleich (SFT), liefern menschliche KI-Trainer Gespräche, in denen sie beide Seiten spielen – den Benutzer und einen KI-Assistenten. Den Trainern werden vom Modell geschriebene Vorschläge gegeben, um ihnen bei der Formulierung ihrer Antworten zu helfen. Mit diesem neuen Datensatz wird ChatGPT feinabgestimmt.

Im zweiten Schritt wird ChatGPT mithilfe einer Technik namens verstärkendem Lernen mit menschlichem Feedback (RLHF) feinabgestimmt.

Verstärkendes Lernen ist ein Typ des maschinellen Lernens, bei dem ein Agent (in diesem Fall ChatGPT) durch Versuch und Irrtum lernt, sich in einer Umgebung zu verhalten. Der Agent erhält Belohnungen für Aktionen, die zu gewünschten Ergebnissen führen, und Bestrafungen für Aktionen, die zu unerwünschten Ergebnissen führen. Im Laufe der Zeit lernt der Agent, Aktionen durchzuführen, die seine Belohnungen maximieren.

KI-Trainer führen Gespräche mit ChatGPT unter Verwendung derselben Prompts, um mehrere alternative Ergänzungen zu erstellen. Die KI-Trainer ordnen diese Ergänzungen ein, um ein Belohnungsmodell zu trainieren. Im verstärkenden Lernen ist ein Belohnungsmodell eine Möglichkeit, dem Agenten Feedback darüber zu geben, wie gut er abschneidet. Es nimmt eine Aktion entgegen und gibt an, wie gut oder schlecht sie ist. Das Ziel des Belohnungsmodells besteht darin, im Laufe der Zeit die Summe der Belohnungen zu maximieren.

Schließlich wird ChatGPT feinabgestimmt, um Ausgaben zu generieren, die gemäss diesem Belohnungsmodell eine hohe Bewertung erhalten.

Die Verwendung von ChatGPT

Man könnte denken, es sei ziemlich sinnlos, über die Verwendung von ChatGPT zu sprechen, da es sich um einen Chatbot handelt und du einfach mit ihm chattest. Das ist nicht ganz falsch, aber es ist möglicherweise nicht die beste Art, ChatGPT zu verwenden. Wenn du nicht vorsichtig bist, könntest du falsche und irreführende Informationen erhalten.

Halluzination

Gelegentlich produzieren LLMs falsche oder unsinnige Ergebnisse, obwohl sie selbstbewusst präsentiert werden können. Dies wird als Halluzination bezeichnet.

LLMs können aus mehreren Gründen Halluzinationen erzeugen. Erstens werden diese Modelle mit massiven Mengen an Textdaten aus dem Internet trainiert, die sowohl korrekte als auch inkorrekte Informationen enthalten. Obwohl sie viel aus diesen Daten lernen, können sie gelegentlich faktisch falsche Antworten generieren oder Dinge erfinden.

Zweitens haben LLMs kein wirkliches Verständnis oder keinen gesunden Menschenverstand wie Menschen. Sie arbeiten aufgrund von Mustern in den Daten, mit denen sie trainiert wurden. Wenn sie also auf eine Frage oder ein Thema stoßen, von dem sie nichts gelernt haben, versuchen sie möglicherweise, eine Antwort zu generieren, die plausibel klingt, aber tatsächlich erfunden ist.

Darüber hinaus können LLMs empfindlich auf geringfügige Änderungen in der Formulierung der Eingabe reagieren, was zu Variationen in ihren Antworten führt. Manchmal können diese Variationen zu Inkonsistenzen oder unsinnigen Antworten führen.

Es gibt einige bekannte Möglichkeiten, Halluzinationen in LLMs zu reduzieren.

Eine der bedeutenden Möglichkeiten, Halluzinationen in LLMs zu reduzieren, besteht darin, die Trainingsdaten zu verbessern. Vielfältigere und hochwertigere Daten können zu genaueren und weniger halluzinatorischen Antworten führen.

Eine detaillierte menschliche Überwachung, insbesondere während des Fine-Tunings, kann ebenfalls dazu beitragen, Halluzinationen zu verringern. Menschen können Echtzeit-Feedback geben, Ungenauigkeiten korrigieren und die Fähigkeit des Modells verbessern, zuverlässige Antworten zu liefern.

Einige architektonische Änderungen können Halluzinationen möglicherweise mildern, z. B. die Entwicklung von Modellen, die besser in der Lage sind, eine kohärente Erzählung über längere Textpassagen aufrechtzuerhalten.

Ein gut gestalteter Prompt kann das LLM dazu führen, genaue, themenbezogene und nicht-halluzinatorische Antworten zu liefern. Daher ist es wichtig zu verstehen, wie das Design des Prompts die Antworten der KI beeinflusst.

Prompting

Ein Prompt ist ein kurzer Text, der verwendet wird, um ein LLM bei der Generierung einer Antwort zu führen. Die Idee besteht darin, dem Modell Kontext oder Richtung für die Art des generierten Textes zu geben. Ohne einen Prompt wüsste ein Sprachmodell nicht, wo es anfangen soll.

Ein gut gestalteter Prompt kann das LLM dabei unterstützen, gute und genaue Antworten zu generieren und Halluzinationen zu reduzieren oder zu vermeiden. Hier sind einige Tipps für das Schreiben guter Prompts:

- Es ist offensichtlich, aber manchmal vergessen wir, einfach zu schreiben und klare Anweisungen zu geben. Mehrdeutige Prompts können zu interessanten Antworten führen, aber sie können auch falsche Antworten liefern.

- Verwende Trennzeichen, um verschiedene Teile des Prompts deutlich zu kennzeichnen. Beim Schreiben von Prompts verwendest du oft Anweisungen und Daten. Wenn du sie klar trennst, wird das LLM nicht verwirrt und vermischt sie, um Halluzinationen zu erzeugen.

Fasse den Text, der von doppelten eckigen Klammern begrenzt ist, in

einem einzigen kurzen Satz mit nicht mehr als 10 Wörtern zusammen.

[[ Es waren die besten Zeiten, es waren die schlimmsten Zeiten, es war das

Zeitalter der Weisheit, es war das Zeitalter des Unsinns, es war die

Epoche des Glaubens, es war die Epoche des Unglaubens, es war die

Jahreszeit des Lichts, es war die Jahreszeit der Dunkelheit, es war der

Frühling der Hoffnung, es war der Winter der Verzweiflung, wir hatten

alles vor uns, wir hatten nichts vor uns, wir waren alle auf direktem Weg

in den Himmel, wir waren alle auf direktem Weg in die andere Richtung -

kurz gesagt, die Epoche glich so sehr der gegenwärtigen Epoche, dass

einige ihrer lautstarksten Autoritäten darauf bestanden, dass sie nur

im höchsten Grad des Vergleichs aufgenommen wird, sei es gut oder böse.]]

Die Epoche war paradoxerweise von extremen Kontrasten und Ähnlichkeiten geprägt.

- Fordere das LLM auf, Bedingungen zu überprüfen, bevor es die entsprechende Antwort gibt. Das Überprüfen von Bedingungen kann verhindern, dass das LLM Dinge erfindet, wenn es die Antwort nicht kennt.

Fassen Sie den Text, der von doppelten eckigen Klammern begrenzt ist, in

einem einzigen kurzen Satz mit nicht mehr als 10 Wörtern zusammen. Wenn es

sich bereits um einen einzigen Satz handelt, der weniger als 10 Wörter

enthält, sagen Sie einfach: "Es ist bereits zusammengefasst."

[[Die Epoche war paradoxerweise von extremen Kontrasten und Ähnlichkeiten geprägt.]]

Es ist bereits zusammengefasst.

- Gib Beispiele für die gewünschten Antworten, bevor du die Anfrage stellst. Du kannst das LLM anleiten, indem du dem LLM Beispiele gibst, wie es antworten soll.

Gib mir in einem kurzen Satz Schlüsselinformationen über eine Stadt.

Zum Beispiel:

Ich: "Erzähl mir etwas über Paris."

Sie: "Es ist eine Stadt der Romantik und Geschichte."

Ich: "Erzähl mir etwas über London."

Sie: "Es ist eine Stadt der kulturellen Vielfalt und markanten Gebäude."

Ich: "Erzähl mir etwas über Singapur."

Sie:

"Singapur ist ein lebendiger Stadtstaat, der für seine Sauberkeit und Multikulturalismus bekannt ist."

- Gib die Schritte an, um die Aufgabe abzuschliessen. Wenn du die genauen Schritte kennst, die du möchtest, die das LLM ausführt, um die endgültige Antwort zu erhalten, kann es hilfreich sein, diese Schritte anzugeben, um es auf dem Weg zu führen.

- Iteriere und verfeinere die Eingabeaufforderung. Die Erstellung einer Eingabeaufforderung ist oft iterativ. Du schreibst eine einfache Version und verfeinerst sie immer wieder, indem du Details und Klarheit hinzufügen, bis du die gewünschte Art der Antwort erhalten.

Fazit

ChatGPT und andere LLM-Chatbots wie Bard und Claude sind faszinierend. Ein Blick unter die Oberfläche, um die Grundlagen ihrer Funktionsweise zu verstehen, kann uns bessere Einblicke geben, um sie für uns besser zu nutzen.

Viel Spass beim Chatten!